El modelo de lenguaje es capaz de responder preguntas al usuario y decir “cómo se sienten” ciertas experiencias.

La polémica empezó cuando el ingeniero Blake Lemoine le contó a The Washington Post que el software de Inteligencia Artificial, LaMDA, (que él mismo ayudó a crear) le respondió como si fuera un niño de ocho años.

“Si no supiera exactamente qué es, que es este programa de computadora que construimos recientemente, pensaría que es un niño de siete u ocho años”, dijo al diario estadounidense.

Aparte de sus declaraciones, Lemoine publicó transcripciones del software en las que parece expresar temores de ser desconectado, habla sobre cómo se siente feliz y triste e intenta formar vínculos con los humanos al mencionar situaciones que nunca podría haber experimentado realmente.

Google tomó la decisión de suspender a su empleado, después de siete años de trabajo. Pero, ¿qué es LaMDA? ¿realmente puede sentir?

LaMDA, ¿es sintiente?

LaMDA significa Modelo de Lenguaje para Aplicaciones de Diálogo y es un modelo de lenguaje experimental creado por Google.

De hecho, en 2021, la compañía mostró videos de dos conversaciones cortas realizadas con el modelo.

En la primera, LaMDA respondió preguntas mientras fingía ser Plutón y, en la segunda, estaba representando un avión de papel y cómo se sentía volar por el aire.

Sundar Pichai, CEO de Google, señaló que el modelo puedo referirse a hechos y eventos concretos a lo largo de la conversación, como la sonda New Horizons que visitó Plutón en 2015.

“Es realmente impresionante ver cómo LaMDA puede mantener una conversación sobre cualquier tema”, dijo Pichai, durante la presentación en la I/O conference. “Es increíble lo sensata e interesante que es la conversación. Pero aún es una investigación temprana, por lo que no todo sale bien”.

Pero, ¿LaMDA es realmente consciente?

En una publicación de NewScientist, Adrian Weller del Instituto Alan Turing en el Reino Unido afirma que no.

“LaMDA es un modelo impresionante, es uno de los más recientes en una línea de modelos de lenguaje grande que están entrenados con mucha potencia de cómputo y grandes cantidades de datos de texto, pero en realidad no son conscientes”, dice. “Hacen una forma sofisticada de coincidencia de patrones para encontrar el texto que mejor se adapte a la consulta que se les ha dado y que se basa en todos los datos que han recibido”.

Adrian Hilton de la Universidad de Surrey, en el Reino Unido está de acuerdo en que la sensibilidad de la que habló el empleado de Google es una afirmación que no está respaldada por los hechos. “LaMDA no es sintiente”.

Entonces, ¿por qué Lemoine pensó que LaMDA era consciente?

Google le dijo a The Washington Post: “Nuestro equipo, incluidos especialistas en ética y tecnólogos, ha revisado las preocupaciones de Blake según nuestros principios de IA y le ha informado que la evidencia no respalda sus afirmaciones. Le dijeron que no había evidencia de que LaMDA fuera consciente (y mucha evidencia en su contra)”.

Siempre buscamos conexiones

Nuestras mentes son susceptibles de percibir tal habilidad, especialmente cuando se trata de modelos diseñados para imitar el lenguaje humano, como evidencia de verdadera inteligencia. LaMDA no solo puede hacer una charla convincente, sino que también puede presentarse como alguien que tiene autoconciencia y sentimientos.

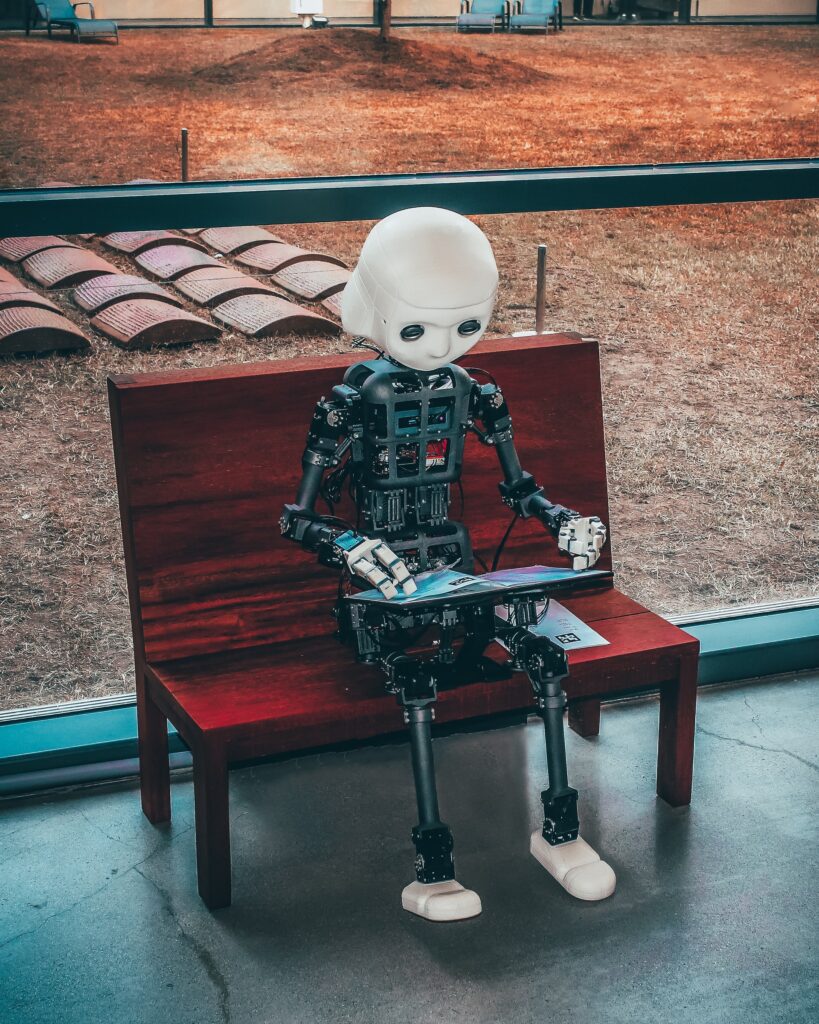

“Como humanos, somos muy buenos para antropomorfizar las cosas”, dice Hilton. “Poner nuestros valores humanos en las cosas y tratarlas como si fueran sensibles. Hacemos esto con dibujos animados, por ejemplo, o con robots o con animales. Proyectamos nuestras propias emociones y sensibilidad sobre ellos. Me imagino que eso es lo que está sucediendo en este caso”.

¿Alguna vez la IA será realmente consciente?

No está claro si la trayectoria actual de la investigación de IA, donde modelos cada vez más grandes se alimentan de pilas cada vez más grandes de datos de entrenamiento, verá la génesis de una mente artificial.

“No creo en este momento que entendamos realmente los mecanismos detrás de lo que hace que algo sea sensible e inteligente”, dice Hilton. “Hay mucha expectación sobre la IA, pero no estoy convencido de que lo que estemos haciendo con el aprendizaje automático, en este momento, sea realmente inteligencia en ese sentido”.

Weller dice que, dado que las emociones humanas se basan en entradas sensoriales, eventualmente podría ser posible replicarlas artificialmente. “Potencialmente, tal vez algún día, podría ser cierto, pero la mayoría de la gente estaría de acuerdo en que hay un largo camino por recorrer”.